Hinter den Kulissen: Unser ML-Labor

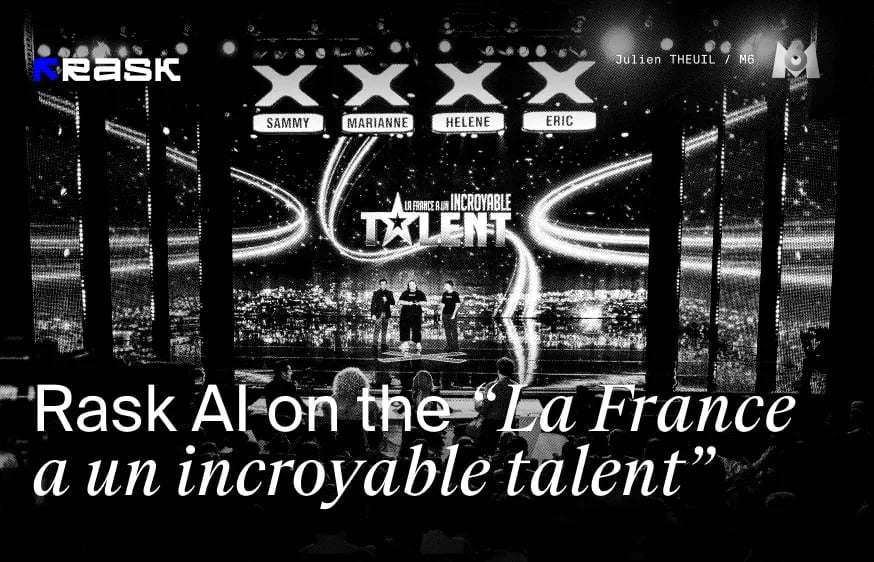

In unserem neuesten Artikel tauchen wir in die aufregende Welt der Lippensynchronisationstechnologie vonRask AI ein und werden dabei von Dima Vypirailenko, dem Leiter für maschinelles Lernen des Unternehmens, unterstützt. Wir nehmen Sie mit hinter die Kulissen des Brask ML Labs, einem Exzellenzzentrum für Technologie, wo wir aus erster Hand erfahren, wie dieses innovative KI-Tool bei der Erstellung und Verbreitung von Inhalten Wellen schlägt. Zu unserem Team gehören ML-Ingenieure und VFX-Synthetikkünstler von Weltrang, die sich nicht nur an die Zukunft anpassen, sondern sie auch gestalten.

Kommen Sie zu uns und erfahren Sie, wie diese Technologie die Kreativbranche verändert, die Kosten senkt und Kreativen hilft, ein weltweites Publikum zu erreichen.

Was ist die Lip-Sync-Technologie?

Eine der größten Herausforderungen bei der Videolokalisierung ist die unnatürliche Bewegung der Lippen. Die Lippensynchronisationstechnologie wurde entwickelt, um Lippenbewegungen mit mehrsprachigen Audiospuren effektiv zu synchronisieren.

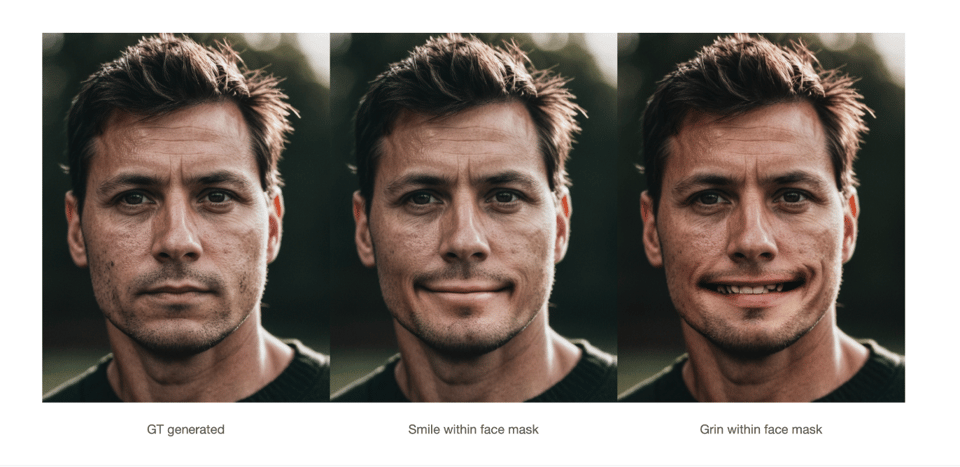

Wie wir in unserem letzten Artikel erfahren haben, ist die Technik der Lippensynchronisation viel komplexer als nur das richtige Timing - man muss die Mundbewegungen richtig hinbekommen. Alle gesprochenen Wörter wirken sich auf das Gesicht des Sprechers aus, z. B. erzeugt ein "O" natürlich eine ovale Form des Mundes, so dass es kein "M" ist, was den Synchronisationsprozess noch viel komplexer macht.

Das neue lippensynchrone Modell mit besserer Qualität wird vorgestellt!

Unser ML-Team hat beschlossen, das bestehende Lippensynchronisationsmodell zu verbessern. Was war der Grund für diese Entscheidung, und was ist neu in dieser Version im Vergleich zur Beta-Version?

Es wurden beträchtliche Anstrengungen unternommen, um das Modell zu verbessern:

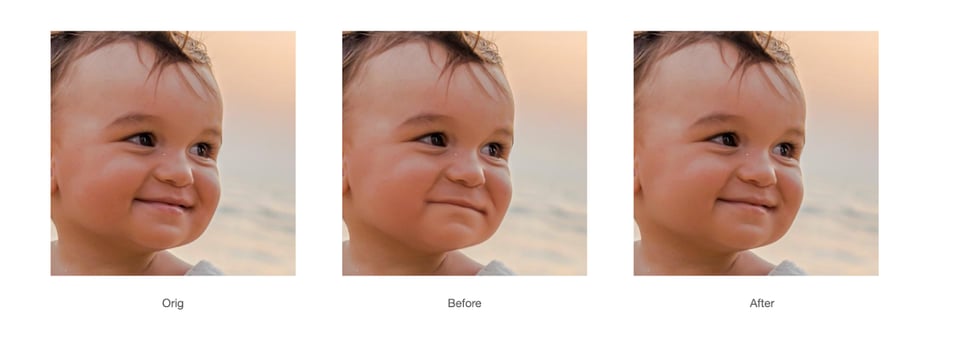

- Verbesserte Genauigkeit: Wir haben die KI-Algorithmen verfeinert, um die phonetischen Details der gesprochenen Sprache besser zu analysieren und abzugleichen, was zu genaueren Lippenbewegungen führt, die in mehreren Sprachen eng mit dem Audio synchronisiert sind.

- VerbesserteNatürlichkeit: Durch die Integration fortschrittlicherer Motion-Capture-Daten und die Verfeinerung unserer maschinellen Lerntechniken haben wir die Natürlichkeit der Lippenbewegungen deutlich verbessert, sodass die Sprache der Charaktere flüssiger und lebensechter wirkt.

- SteigerteGeschwindigkeit und Effizienz: Wir haben das Modell so optimiert, dass Videos schneller verarbeitet werden können, ohne dass die Qualität darunter leidet. Dies ermöglicht kürzere Durchlaufzeiten für Projekte, die eine umfangreiche Lokalisierung erfordern.

- Einbeziehung von Benutzer-Feedback: Wir haben aktiv das Feedback der Nutzer der Betaversion eingeholt und ihre Erkenntnisse in den Entwicklungsprozess einfließen lassen, um bestimmte Probleme zu lösen und die allgemeine Nutzerzufriedenheit zu erhöhen.

Wie genau synchronisiert unser KI-Modell die Lippenbewegungen mit dem übersetzten Ton?

Dima: "Unser KI-Modell kombiniert die Informationen aus dem übersetzten Audio mit Informationen über das Gesicht der Person im Bild und fügt diese dann in die endgültige Ausgabe ein. Durch diese Integration wird sichergestellt, dass die Lippenbewegungen genau mit der übersetzten Sprache synchronisiert werden, was ein nahtloses Seherlebnis ermöglicht".

Welche einzigartigen Funktionen machen Premium Lip-Sync ideal für hochwertige Inhalte?

Dima: "Premium Lip-sync wurde speziell für die Verarbeitung hochwertiger Inhalte entwickelt und verfügt über einzigartige Funktionen wie Multisprecher-Fähigkeit und Unterstützung für hohe Auflösungen. Es kann Videos mit einer Auflösung von bis zu 2K verarbeiten und stellt sicher, dass die visuelle Qualität ohne Kompromisse erhalten bleibt. Darüber hinaus ermöglicht die Multisprecherfunktion eine präzise Lippensynchronisation zwischen verschiedenen Sprechern innerhalb desselben Videos, was die Anwendung für komplexe Produktionen mit mehreren Charakteren oder Sprechern sehr effektiv macht. Diese Funktionen machen Premium Lipsync zur ersten Wahl für Produzenten, die professionelle Inhalte erstellen wollen.

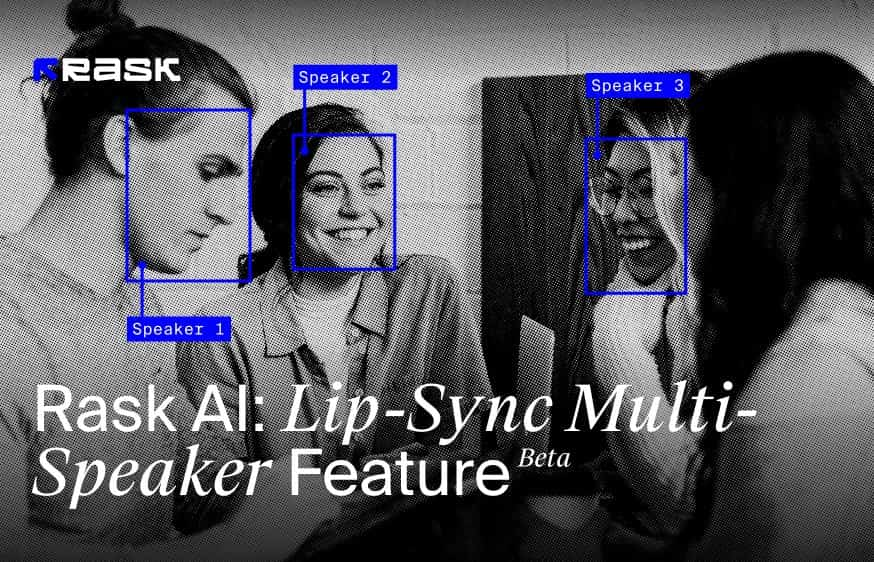

Und was ist eine lippensynchrone Multi-Lautsprecher-Funktion?

Die Funktion Multi-Speaker Lip-Sync wurde entwickelt, um Lippenbewegungen und gesprochenes Audio in Videos mit mehreren Personen genau zu synchronisieren. Diese fortschrittliche Technologie identifiziert und unterscheidet zwischen mehreren Gesichtern in einem Einzelbild und stellt sicher, dass die Lippenbewegungen jeder Person entsprechend ihrer gesprochenen Worte korrekt animiert werden.

So funktioniert die Lippensynchronisation mit mehreren Lautsprechern:

- Gesichtserkennung im Bild: Die Funktion erkennt zunächst alle im Videobild vorhandenen Gesichter, unabhängig von ihrer Anzahl. Sie ist in der Lage, jede einzelne Person zu identifizieren, was für eine genaue Lippensynchronisation entscheidend ist.

- AudioMatching: Während der Videowiedergabe richtet die Technologie die Audiospur speziell auf die sprechende Person aus. Dieser präzise Abgleich stellt sicher, dass die Stimme und die Lippenbewegungen synchronisiert sind.

- Lippenbewegungssynchronisation: Sobald die sprechende Person identifiziert ist, zeichnet die Lippensynchronisationsfunktion die Lippenbewegungen nur für die sprechende Person neu. Bei nicht sprechenden Personen im Bild werden die Lippenbewegungen nicht verändert, so dass sie im gesamten Video ihren natürlichen Zustand beibehalten. Diese Synchronisierung bezieht sich ausschließlich auf den aktiven Sprecher, so dass sie auch bei Stimmen aus dem Off oder mehreren Gesichtern in der Szene wirksam ist.

- Behandlungstatischer Bilder von Lippen: Interessanterweise ist diese Technologie auch ausgeklügelt genug, um Lippenbewegungen auf statischen Bildern von Lippen neu zu zeichnen, wenn sie im Videobild erscheinen, was ihre vielseitigen Fähigkeiten unter Beweis stellt.

Diese Multi-Speaker Lip-Sync-Funktion erhöht den Realismus und das Engagement des Zuschauers in Szenen mit mehreren Sprechern oder komplexen Videoeinstellungen, indem sie sicherstellt, dass sich nur die Lippen der sprechenden Personen in Übereinstimmung mit dem Audio bewegen. Dieser gezielte Ansatz trägt dazu bei, dass der Fokus auf dem aktiven Sprecher bleibt und die natürliche Dynamik von Gruppeninteraktionen in Videos erhalten bleibt.

Aus nur einem Video in einer beliebigen Sprache können Sie Hunderte von personalisierten Videos mit verschiedenen Angeboten in mehreren Sprachen erstellen. Diese Vielseitigkeit revolutioniert die Art und Weise, wie Vermarkter mit unterschiedlichen und globalen Zielgruppen in Kontakt treten können, und steigert die Wirkung und Reichweite von Werbeinhalten.

Wie schaffen Sie das Gleichgewicht zwischen Qualität und Verarbeitungsgeschwindigkeit beim neuen Premium Lip-sync?

Dima: "Die Balance zwischen hoher Qualität und hoher Verarbeitungsgeschwindigkeit bei Premium Lipsync ist eine Herausforderung, aber wir haben große Fortschritte bei der Optimierung der Inferenz unseres Modells gemacht. Diese Optimierung ermöglicht es uns, die bestmögliche Qualität bei einer angemessenen Geschwindigkeit auszugeben".

Gibt es interessante Unzulänglichkeiten oder Überraschungen, auf die Sie beim Training des Modells gestoßen sind?

Außerdem hat sich die Arbeit mit Okklusionen im Mundbereich als recht schwierig erwiesen. Diese Elemente erfordern viel Liebe zum Detail und eine ausgefeilte Modellierung, um eine realistische und genaue Darstellung in unserer Lippensynchronisationstechnologie zu erreichen.

Wie gewährleistet das ML-Team den Schutz der Nutzerdaten bei der Verarbeitung von Videomaterial?

Dima: Unser ML-Team nimmt die Privatsphäre und den Schutz der Nutzerdaten sehr ernst. Für das Lipsync-Modell verwenden wir keine Kundendaten für das Training, so dass jedes Risiko eines Identitätsdiebstahls ausgeschlossen ist. Für das Training unseres Modells verwenden wir ausschließlich Open-Source-Daten, die mit entsprechenden Lizenzen ausgestattet sind. Darüber hinaus arbeitet das Modell als separate Instanz für jeden Nutzer, wodurch sichergestellt wird, dass das endgültige Video nur an den jeweiligen Nutzer geliefert wird und jegliche Datenverflechtung vermieden wird.

Im Kern geht es uns darum, Kreative zu unterstützen und den verantwortungsvollen Einsatz von KI bei der Erstellung von Inhalten zu gewährleisten, wobei wir uns auf die gesetzlichen Rechte und ethische Transparenz konzentrieren. Wir garantieren, dass Ihre Videos, Fotos, Stimmen und Konterfeis niemals ohne ausdrückliche Erlaubnis verwendet werden, um den Schutz Ihrer persönlichen Daten und kreativen Ressourcen zu gewährleisten.

Wir sind stolze Mitglieder der Coalition for Content Provenance and Authenticity (C2PA) und der Content Authenticity Initiative, was unser Engagement für die Integrität und Authentizität von Inhalten im digitalen Zeitalter unterstreicht. Darüber hinaus wurde unsere Gründerin und CEO Maria Chmir in das Verzeichnis Women in AI Ethics™ aufgenommen, was unsere Führungsrolle bei ethischen KI-Praktiken unterstreicht.

Wie sehen die Zukunftsaussichten für die Entwicklung der Lippensynchronisationstechnik aus? Gibt es bestimmte Bereiche, die Sie besonders reizen?

Dima: Wir glauben, dass unsere Lippensynchronisationstechnologie als Grundlage für die weitere Entwicklung hin zu digitalen Avataren dienen kann. Wir stellen uns eine Zukunft vor, in der jeder Inhalte erstellen und lokalisieren kann, ohne dass Kosten für die Videoproduktion anfallen.

Kurzfristig, innerhalb der nächsten zwei Monate, wollen wir die Leistung und Qualität unseres Modells verbessern. Unser Ziel ist es, einen reibungslosen Betrieb bei 4K-Videos zu gewährleisten und die Funktionalität bei übersetzten Videos in asiatische Sprachen zu verbessern. Diese Fortschritte sind von entscheidender Bedeutung, da wir die Zugänglichkeit und Nutzbarkeit unserer Technologie erweitern und so den Weg für innovative Anwendungen bei der Erstellung digitaler Inhalte ebnen wollen.Nie war es so einfach, Sprachbarrieren zu überwinden! Testen Sie unsere verbesserte Lippensynchronisationsfunktion und senden Sie uns Ihr Feedback zu dieser Funktion.

FAQ

Die Lippensynchronisation ist in den Tarifen Creator Pro, Archive Pro, Business und Enterprise verfügbar.

Eine Minute Lippensynchronisation entspricht einer Minute, die von Ihrem Gesamtminutenguthaben abgezogen wird.

Die Minuten für die Lippensynchronisation werden genau wie bei der Synchronisation Ihrer Videos abgezogen.

Die Lippensynchronisation wird getrennt von der Synchronisation berechnet. Um beispielsweise ein 1-minütiges Video in eine Sprache zu übersetzen und lippensynchron zu machen, benötigen Sie 2 Minuten.

Bevor Sie lippensynchron machen, können Sie 1 kostenlose Minute testen, um die Qualität der Technologie zu beurteilen.

Die Geschwindigkeit der Lippensynchronisation hängt von der Anzahl der Sprecher im Video, der Dauer, der Qualität und der Größe des Videos ab.

Hier zum Beispiel die ungefähre Geschwindigkeit der Lippensynchronisation für verschiedene Videos:

Videos mit einem Sprecher

- 4 Minuten Video 1080p ≈ 29 Minuten

- 10 Minuten 1080p ≈ 2 Stunden 10 Minuten

- 10 Minuten 4K-Video ≈ 8 Stunden

Videos mit 3 Sprechern:

- 10 Minuten 1080p ≈ 5 Stunden 20 Minuten

- Laden Sie Ihr Video über den Link von YouTube oder Google Drive hoch oder laden Sie die Datei direkt von Ihrem Gerät hoch. Wählen Sie die Zielsprache und klicken Sie auf die Schaltfläche "Übersetzen".

- Fügen Sie Ihrem Video in Rask AI über die Schaltfläche "Video synchronisieren" einen Voiceover hinzu.

- Um zu prüfen, ob Ihr Video mit der Lippensynchronisation kompatibel ist, klicken Sie auf die Schaltfläche "Lippensynchronisation prüfen".

- Wenn sie kompatibel ist, tippen Sie auf die Schaltfläche Lippensynchronisation.

- Wählen Sie als Nächstes die Anzahl der Gesichter in Ihrem Video aus - entweder "1" oder "2+" - und tippen Sie dann auf "Start Lip-sync". Nur als Vorwarnung: Es geht um die Anzahl der Gesichter, nicht der Sprecher.

.jpg)

.webp)

![8 Beste Video-Übersetzer-App für Content-Ersteller [von 2024]](https://rask.ai/cdn-cgi/image/width=960,format=auto,fit=scale-down/https://cdn.prod.website-files.com/63d41bc99674c403e4a7cef7/6668a3dcd3175bd1d1c73c81_Best%20video%20translator%20apps%20cover.webp)

![Beste AI-Synchronisationssoftware für die Videolokalisierung [von 2024]](https://rask.ai/cdn-cgi/image/width=960,format=auto,fit=scale-down/https://cdn.prod.website-files.com/63d41bc99674c403e4a7cef7/66685014f68137eb05c89c16_Cover.webp)

.webp)

Rask%20Lens%20A%20Recap%204.webp)